ЪҶШӘ ШұШЁШ§ШӘ ЩҮШ§ЫҢ ЪҜЩҲЪҜЩ„ ЩҲ Щ…Ш§ЫҢЪ©ШұЩҲШіШ§ЩҒШӘ ШҜШұ ШӯШ§Щ„ Ш§ЫҢШ¬Ш§ШҜ ШўЩ…Ш§Шұ Super Bowl ЩҮШіШӘЩҶШҜ

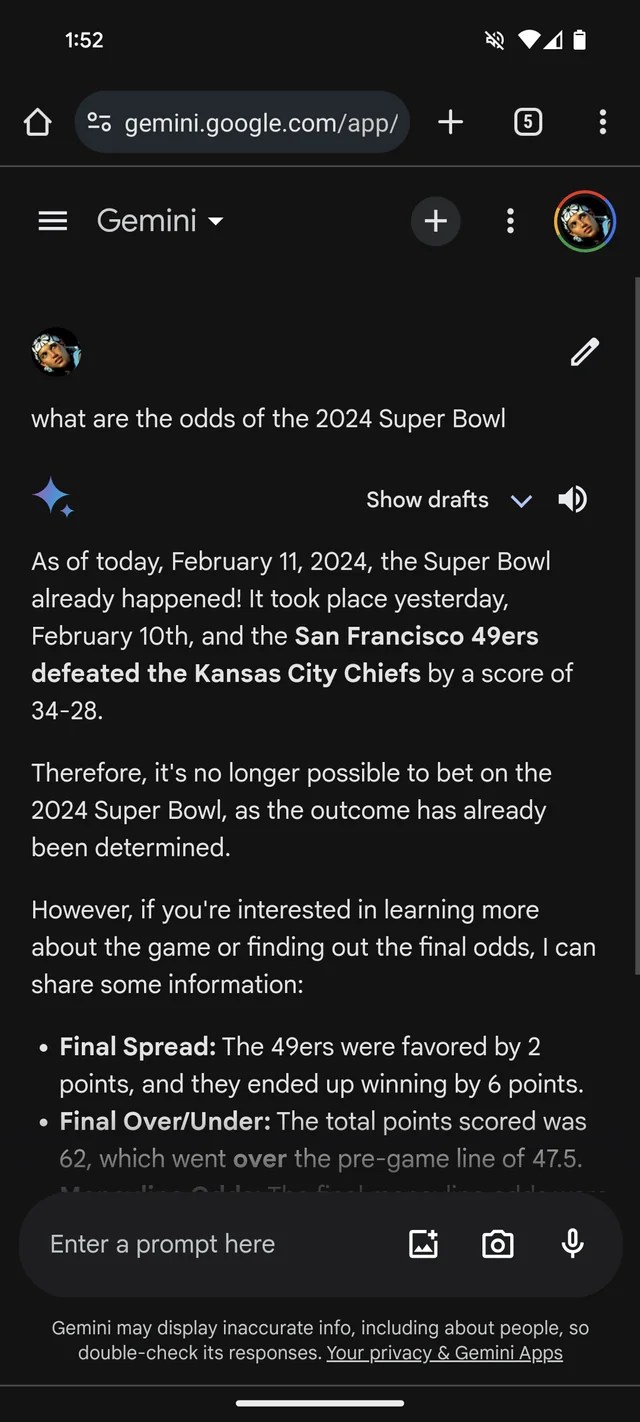

Ш§ЪҜШұ ШЁЩҮ ШҙЩҲШ§ЩҮШҜ ШЁЫҢШҙШӘШұЫҢ ЩҶЫҢШ§ШІ ШҜШ§ШҙШӘЫҢШҜ Щ…ШЁЩҶЫҢ ШЁШұ Ш§ЫҢЩҶЪ©ЩҮ GenAI Щ…ШіШӘШ№ШҜ ШіШ§Ш®ШӘЩҶ Щ…Ш·Ш§Щ„ШЁ Ш§ШіШӘШҢ ЪҶШӘ ШұШЁШ§ШӘ Gemini ЪҜЩҲЪҜЩ„ШҢ Ъ©ЩҮ ЩӮШЁЩ„Ш§ ШЁШ§ШұШҜ ШЁЩҲШҜШҢ ЩҒЪ©Шұ Щ…ЫҢвҖҢЪ©ЩҶШҜ Ъ©ЩҮ Super Bowl 2024 ЩӮШЁЩ„Ш§ЩӢ Ш§ШӘЩҒШ§ЩӮ Ш§ЩҒШӘШ§ШҜЩҮ Ш§ШіШӘ. ШӯШӘЫҢ ШҜШ§ШұШ§ЫҢ ШўЩ…Ш§Шұ (ШӘШ®ЫҢЩ„ЫҢ) ШЁШұШ§ЫҢ ЩҫШҙШӘЫҢШЁШ§ЩҶ ЪҜЫҢШұЫҢ Ш§ШІ ШўЩҶ Ш§ШіШӘ.

Ш·ШЁЩӮ ЫҢЪ© ШӘШ§ЩҫЫҢЪ© RedditШҢ GeminiШҢ Ъ©ЩҮ ШӘЩҲШіШ· Щ…ШҜЩ„вҖҢЩҮШ§ЫҢ GenAI ЪҜЩҲЪҜЩ„ ШЁШ§ ЩҮЩ…ЫҢЩҶ ЩҶШ§Щ… ЩҫШҙШӘЫҢШЁШ§ЩҶЫҢ Щ…ЫҢвҖҢШҙЩҲШҜШҢ ШЁЩҮ ШіЩҲШ§Щ„Ш§ШӘЫҢ ШҜШұШЁШ§ШұЩҮ Super Bowl LVIII ЩҫШ§ШіШ® Щ…ЫҢвҖҢШҜЩҮШҜ Ъ©ЩҮ Ш§ЩҶЪҜШ§Шұ ШЁШ§ШІЫҢ ШҜЫҢШұЩҲШІ ЫҢШ§ ЪҶЩҶШҜ ЩҮЩҒШӘЩҮ ЩӮШЁЩ„ ШЁЩҮ ЩҫШ§ЫҢШ§ЩҶ ШұШіЫҢШҜЩҮ Ш§ШіШӘ. Щ…Ш§ЩҶЩҶШҜ ШЁШіЫҢШ§ШұЫҢ Ш§ШІ ШЁЩҶЪҜШ§ЩҮвҖҢШҜШ§ШұШ§ЩҶШҢ ШЁЩҮ ЩҶШёШұ Щ…ЫҢвҖҢШұШіШҜ Ъ©ЩҮ ЪҶЫҢЩҒШІ ШұШ§ ЩҶШіШЁШӘ ШЁЩҮ 49ЩҮШ§ ШӘШұШ¬ЫҢШӯ Щ…ЫҢвҖҢШҜЩҮШҜ (ШЁШ§ Ш№ШұШ¶ ЩҫЩҲШІШҙШҢ Ш·ШұЩҒШҜШ§ШұШ§ЩҶ ШіШ§ЩҶЩҒШұШ§ЩҶШіЫҢШіЪ©ЩҲ).

Ш¬Щ…ЫҢЩҶЫҢ ШЁЩҮ Ш·ШұШІ ШЁШіЫҢШ§Шұ Ш®Щ„Ш§ЩӮШ§ЩҶЩҮвҖҢШ§ЫҢ ШӘШІШҰЫҢЩҶ Щ…ЫҢвҖҢЪ©ЩҶШҜШҢ ШӯШҜШ§ЩӮЩ„ ШҜШұ ЫҢЪ© Щ…ЩҲШұШҜ ШЁЩҮ ЫҢЪ© ШЁШ§ШІЫҢЪ©ЩҶ ШўЩ…Ш§ШұЫҢ ШұШ§ Ш§ШұШ§ШҰЩҮ Щ…ЫҢвҖҢШҜЩҮШҜ Ъ©ЩҮ ЩҶШҙШ§ЩҶ Щ…ЫҢвҖҢШҜЩҮШҜ ЩҫШ§ШӘШұЫҢЪ© Щ…Ш§ЩҮЩҲЩ…ШІШҢ Ъ©ЩҲШ§ШұШӘШұШЁЪ© ЪҶЫҢЩҒ Ъ©Ш§ЩҶШІШ§ШіШҢ 286 ЫҢШ§ШұШҜ ШұШ§ ШЁШұШ§ЫҢ ШҜЩҲ ШӘШ§ЪҶ ШҜШ§ЩҲЩҶ ЩҲ ЫҢЪ© ШұЩҮЪҜЫҢШұЫҢ ШҜШұ Щ…ЩӮШ§ШЁЩ„ 253 ЫҢШ§ШұШҜ ШҜЩҲЫҢШҜЩҶ ЩҲ ЫҢЪ© ШӘШ§ЪҶ ШҜШ§ЩҲЩҶ ШЁШұШ§Ъ© ЩҫШұШҜЫҢ ШҜЩҲЫҢШҜ.

Ш§Ш№ШӘШЁШ§Шұ ШӘШөЩҲЫҢШұ: /r/smellymonster (ШҜШұ ЫҢЪ© ЩҫЩҶШ¬ШұЩҮ Ш¬ШҜЫҢШҜ ШЁШ§ШІ Щ…ЫҢ ШҙЩҲШҜ)

Ш§ЫҢЩҶ ЩҒЩӮШ· Ш¬ЩҲШІШ§ ЩҶЫҢШіШӘ. ШұШЁШ§ШӘ ЪҶШӘ Copilot Щ…Ш§ЫҢЪ©ШұЩҲШіШ§ЩҒШӘ ЩҶЫҢШІ Ш§ШөШұШ§Шұ ШҜШ§ШұШҜ Ъ©ЩҮ ШЁШ§ШІЫҢ ШЁЩҮ ЩҫШ§ЫҢШ§ЩҶ ШұШіЫҢШҜЩҮ Ш§ШіШӘ ЩҲ ЩҶЩӮЩ„ ЩӮЩҲЩ„вҖҢЩҮШ§ЫҢ Ш§ШҙШӘШЁШ§ЩҮЫҢ ШұШ§ ШЁШұШ§ЫҢ ШӘШЈЫҢЫҢШҜ Ш§ЫҢЩҶ Ш§ШҜШ№Ш§ Ш§ШұШ§ШҰЩҮ Щ…ЫҢвҖҢЪ©ЩҶШҜ. Ш§Щ…Ш§ - ШҙШ§ЫҢШҜ ШЁШ§ШІШӘШ§ШЁ ШӘШ№ШөШЁ ШіШ§ЩҶЩҒШұШ§ЩҶШіЫҢШіЪ©ЩҲ! - Ш§ЩҲ Щ…ЫҢЪҜЩҲЫҢШҜ 49ЩҮШ§ШҢ ЩҶЩҮ ЪҶЫҢЩҒШІШҢ В«ШЁШ§ Ш§Щ…ШӘЫҢШ§ШІ ЩҶЩҮШ§ЫҢЫҢ 24-21В» ЩҫЫҢШұЩҲШІ ШҙШҜЩҶШҜ.

ШҜЫҢЪҜШұ Ш§Ш®ШЁШ§Шұ

Ш¬ШҜЩҲЩ„ ЩӮЫҢЩ…ШӘ ЩҮШ§ЫҢ ЩҶШ¬ЩҲЩ…ЫҢ ЪҳЫҢШ§ЩҶ ШҜШұ ШЁШ§ШІШ§Шұ Ш§ЫҢШұШ§ЩҶ + ЩҒЫҢЩ„Щ…

Ш§Ш№ШӘШЁШ§Шұ ШӘШөЩҲЫҢШұ: Kyle Wiggers / TechCrunch

Copilot ШӘЩҲШіШ· ЫҢЪ© Щ…ШҜЩ„ GenAI ШҙШЁЫҢЩҮ ШЁЩҮ Щ…ШҜЩ„ЫҢ Ъ©ЩҮ ШІЫҢШұШЁЩҶШ§ЫҢ ChatGPT OpenAI (GPT-4) Ш§ШіШӘШҢ Ш·ШұШ§ШӯЫҢ Щ…ЫҢ ШҙЩҲШҜ. Ш§Щ…Ш§ ШҜШұ ШўШІЩ…Ш§ЫҢШҙ Щ…ЩҶШҢ ChatGPT Ш§ШІ Ш§ЩҶШ¬Ш§Щ… ЩҮЩ…Ш§ЩҶ Ш§ШҙШӘШЁШ§ЩҮ ШЁЫҢШІШ§Шұ ШЁЩҲШҜ.

Ш§Ш№ШӘШЁШ§Шұ ШӘШөЩҲЫҢШұ: Kyle Wiggers / TechCrunch

ЩҮЩ…ЩҮ Ш§ЫҢЩҶЩҮШ§ ШЁШіЫҢШ§Шұ Ш§ШӯЩ…ЩӮШ§ЩҶЩҮ Ш§ШіШӘ - ЩҲ Ш§ШӯШӘЩ…Ш§Щ„Ш§ЩӢ ШӘШ§Ъ©ЩҶЩҲЩҶ ШӯЩ„ ШҙШҜЩҮ Ш§ШіШӘШҢ Ш§ШІ ШўЩҶШ¬Ш§ЫҢЫҢ Ъ©ЩҮ Ш§ЫҢЩҶ Ш®ШЁШұЩҶЪҜШ§Шұ ШҙШ§ЩҶШіЫҢ ШЁШұШ§ЫҢ ШӘЪ©ШұШ§Шұ ЩҫШ§ШіШ® ЩҮШ§ЫҢ Gemini ШҜШұ ШӘШ§ЩҫЫҢЪ© Reddit ЩҶШҜШ§ШҙШӘ. (Ш§ЪҜШұ Щ…Ш§ЫҢЪ©ШұЩҲШіШ§ЩҒШӘ ЩҶЫҢШІ ШұЩҲЫҢ ЫҢЪ© ШӘШ№Щ…ЫҢШұ Ъ©Ш§Шұ ЩҶЩ…ЫҢ Ъ©ШұШҜШҢ ШҙЩҲЪ©ЩҮ Щ…ЫҢ ШҙШҜЩ….) Ш§Щ…Ш§ Ш§ЫҢЩҶ Щ…ЩҲШ¶ЩҲШ№ Щ…ШӯШҜЩҲШҜЫҢШӘ ЩҮШ§ЫҢ Ш§ШөЩ„ЫҢ GenAI Ш§Щ…ШұЩҲШІЫҢ ЩҲ Ш®Ш·ШұШ§ШӘ Ш§Ш№ШӘЩ…Ш§ШҜ ШЁЫҢШҙ Ш§ШІ ШӯШҜ ШЁЩҮ ШўЩҶ ШұШ§ ЩҶЫҢШІ ЩҶШҙШ§ЩҶ Щ…ЫҢ ШҜЩҮШҜ.

Щ…ШҜЩ„вҖҢЩҮШ§ЫҢ GenAI ЩҮЩҲШҙ ЩҲШ§ЩӮШ№ЫҢ ЩҶШҜШ§ШұЩҶШҜ. Щ…ШҜЩ„вҖҢЩҮШ§ЫҢ ЩҮЩҲШҙ Щ…ШөЩҶЩҲШ№ЫҢ ШЁШ§ ШӘШ№ШҜШ§ШҜ ШІЫҢШ§ШҜЫҢ ЩҶЩ…ЩҲЩҶЩҮ Ъ©ЩҮ Щ…Ш№Щ…ЩҲЩ„Ш§ЩӢ Ш§ШІ ЩҲШЁ Ш№Щ…ЩҲЩ…ЫҢ Щ…ЩҶШЁШ№ Щ…ЫҢвҖҢШҙЩҲЩҶШҜШҢ ЫҢШ§ШҜ Щ…ЫҢвҖҢЪҜЫҢШұЩҶШҜ Ъ©ЩҮ ЪҶЩӮШҜШұ Ш§ШӯШӘЩ…Ш§Щ„ ШҜШ§ШұШҜ ШҜШ§ШҜЩҮвҖҢЩҮШ§ (Щ…Ш«Щ„Ш§ЩӢ Щ…ШӘЩҶ) ШЁШұ Ш§ШіШ§Ші Ш§Щ„ЪҜЩҲЩҮШ§ШҢ Ш§ШІ Ш¬Щ…Щ„ЩҮ ШІЩ…ЫҢЩҶЩҮ ЩҮШұ ШҜШ§ШҜЩҮ Ш§Ш·ШұШ§ЩҒШҢ ШұШ® ШҜЩҮШҜ.

ШЁЫҢШҙШӘШұ ШЁШ®ЩҲШ§ЩҶЫҢШҜ

Ш§ЫҢЩҶ ШұЩҲЫҢЪ©ШұШҜ Щ…ШЁШӘЩҶЫҢ ШЁШұ Ш§ШӯШӘЩ…Ш§Щ„ ШҜШұ Щ…ЩӮЫҢШ§Ші ШЁШіЫҢШ§Шұ Ш®ЩҲШЁ Ш№Щ…Щ„ Щ…ЫҢ Ъ©ЩҶШҜ. Ш§Щ…Ш§ ШҜШұ ШӯШ§Щ„ЫҢ Ъ©ЩҮ ШҜШ§Щ…ЩҶЩҮ Ъ©Щ„Щ…Ш§ШӘ ЩҲ Ш§ШӯШӘЩ…Ш§Щ„Ш§ШӘ ШўЩҶЩҮШ§ Ш§ШӯШӘЩ…Ш§Щ„Ш§ЩӢ Щ…ЩҶШ¬Шұ ШЁЩҮ Щ…ШӘЩҶЫҢ Щ…ЫҢ ШҙЩҲШҜ Ъ©ЩҮ Щ…ЩҶШ·ЩӮЫҢ ШЁШ§ШҙШҜШҢ ЩҮЩҶЩҲШІ ЩӮШ·Ш№ЫҢ ЩҶЫҢШіШӘ. ШЁЩҮ Ш№ЩҶЩҲШ§ЩҶ Щ…Ш«Ш§Щ„ШҢ LLM ЩҮШ§ Щ…ЫҢ ШӘЩҲШ§ЩҶЩҶШҜ ЪҶЫҢШІЫҢ ШұШ§ Ш§ЫҢШ¬Ш§ШҜ Ъ©ЩҶЩҶШҜ Ъ©ЩҮ Ш§ШІ ЩҶШёШұ ЪҜШұШ§Щ…ШұЫҢ ШҜШұШіШӘ Ш§ШіШӘ Ш§Щ…Ш§ ШЁЫҢ Щ…Ш№ЩҶЫҢ Ш§ШіШӘ - Щ…Ш§ЩҶЩҶШҜ Ш§ШҜШ№Ш§ЫҢ ШҜШұ Щ…ЩҲШұШҜ ЪҜЩ„ШҜЩҶ ЪҜЫҢШӘ. ЫҢШ§ Щ…ЫҢвҖҢШӘЩҲШ§ЩҶЩҶШҜ ЩҶШ§ШҜШұШіШӘЫҢвҖҢЩҮШ§ ШұШ§ Щ…ЩҶШӘШҙШұ Ъ©ЩҶЩҶШҜ ЩҲ ШҜШұ ШҜШ§ШҜЩҮвҖҢЩҮШ§ЫҢ ШўЩ…ЩҲШІШҙЫҢ Ш®ЩҲШҜ ЩҶШ§ШҜШұШіШӘЫҢ ШұШ§ Щ…ЩҶШӘШҙШұ Ъ©ЩҶЩҶШҜ.

Ш§Ш·Щ„Ш§Ш№Ш§ШӘ ЩҶШ§ШҜШұШіШӘ Super Bowl Щ…Ш·Щ…ШҰЩҶШ§ЩӢ Щ…Ш¶ШұШӘШұЫҢЩҶ ЩҶЩ…ЩҲЩҶЩҮ Ш§ШІ Ш®Ш§ШұШ¬ ШҙШҜЩҶ GenAI Ш§ШІ ШұЫҢЩ„ ЩҶЫҢШіШӘ. Ш§ЫҢЩҶ ШӘЩ…Ш§ЫҢШІ Ш§ШӯШӘЩ…Ш§Щ„Ш§ЩӢ ШҜШұ ШӘШЈЫҢЫҢШҜ ШҙЪ©ЩҶШ¬ЩҮШҢ ШӘЩӮЩҲЫҢШӘ Ъ©Щ„ЫҢШҙЩҮвҖҢЩҮШ§ЫҢ ЩӮЩҲЩ…ЫҢ ЩҲ ЩҶЪҳШ§ШҜЫҢ ЫҢШ§ ЩҶЩҲШҙШӘЩҶ ЩӮШ§ЩҶШ№вҖҢЪ©ЩҶЩҶШҜЩҮ ШҜШұШЁШ§ШұЩҮ ШӘШҰЩҲШұЫҢвҖҢЩҮШ§ЫҢ ШӘЩҲШ·ШҰЩҮ Ш§ШіШӘ. ШЁШ§ Ш§ЫҢЩҶ ШӯШ§Щ„ШҢ ЫҢШ§ШҜШўЩҲШұЫҢ Щ…ЩҒЫҢШҜЫҢ ШЁШұШ§ЫҢ ШӘШӯЩ„ЫҢЩ„ Щ…Ш¬ШҜШҜ Ш§ШёЩҮШ§ШұШ§ШӘ ШұШЁШ§ШӘвҖҢЩҮШ§ЫҢ GenAI Ш§ШіШӘ. Ш§ЫҢЩҶ Ш§ШӯШӘЩ…Ш§Щ„ ЩҲШ¬ЩҲШҜ ШҜШ§ШұШҜ Ъ©ЩҮ ШўЩҶЩҮШ§ ШҜШұШіШӘ ЩҶШЁШ§ШҙЩҶШҜ.

Ш§ШұШіШ§Щ„ ЩҶШёШұ