PySpark برای مبتدیان – نحوه پردازش داده ها با Apache Spark و Python

اگر در حال غواصی در دنیای داده های بزرگ هستید، احتمالاً با اصطلاح PySpark برخورد کرده اید.

PySpark ابزاری است که مدیریت و تجزیه و تحلیل مجموعه داده های بزرگ را آسان تر می کند. در این مقاله، اصول اولیه PySpark، مزایای آن و نحوه شروع کار با آن را خواهیم دید.

Pyspark چیست؟

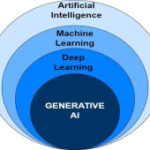

PySpark یک API پایتون برای Apache Spark است که یک چارچوب پردازش داده بزرگ است.

Spark برای پردازش داده ها و وظایف یادگیری ماشینی در مقیاس بزرگ طراحی شده است. با PySpark می توانید برنامه های Spark را با استفاده از Python بنویسید.

یکی از دلایل اصلی استفاده از PySpark سرعت آن است. PySpark می تواند داده ها را بسیار سریعتر از چارچوب های پردازش داده سنتی پردازش کند.

این به این دلیل است که Pyspark وظایف را در چندین ماشین توزیع می کند و آن را فوق العاده کارآمد می کند.

مزیت دیگر سهولت استفاده است. اگر با پایتون آشنایی دارید، یادگیری PySpark برای شما آسان است. از نحو و کتابخانه های آشنای پایتون استفاده می کند، پس می توانید به سرعت سرعت خود را افزایش دهید.

مقیاس پذیری یکی دیگر از مزایای کلیدی PySpark است. چه با یک مجموعه داده کوچک کار کنید و چه با یک مجموعه عظیم، PySpark می تواند همه آن را مدیریت کند.

Pyspark از یک ماشین به مجموعه ای متشکل از هزاران ماشین مقیاس می شود. این به این معنی است که می توانید از کوچک شروع کنید و با افزایش داده های خود گسترش دهید.

PySpark همچنین با سایر ابزارهای کلان داده مانند Hadoop و Apache Hive به خوبی ادغام می شود. این امر آن را به یک انتخاب همه کاره برای کارهای مهندسی داده تبدیل می کند.

نحوه کار با Pyspark

حالا بیایید در مورد شروع کار با PySpark صحبت کنیم.

قبل از شروع، باید پایتون و جاوا را روی سیستم خود نصب کنید. شما همچنین باید Apache Spark را نصب کنید. می توانید آن را از وب سایت رسمی Spark دانلود کنید.

پس از ایجاد این پیش نیازها، می توانید PySpark را با استفاده از pip ، نصب کننده بسته Python نصب کنید.

pip install pysparkپس از نصب PySpark، می توانید از آن برای پردازش داده ها استفاده کنید.

شما می توانید یک جلسه Spark ایجاد کنید، که نقطه ورود برای هر برنامه Spark است. از آنجا، می توانید داده های خود را در یک DataFrame پایتون بارگذاری کنید.

DataFrame مجموعه ای توزیع شده از داده ها است که در ستون های نامگذاری شده سازماندهی شده اند. DataFrames شبیه جداول موجود در پایگاه داده است و دستکاری داده های شما را آسان می کند.

میتوانید عملیات مختلفی را روی DataFrames انجام دهید، مانند فیلتر کردن، گروهبندی و جمعآوری دادهها. PySpark طیف گسترده ای از توابع را برای کمک به شما در انجام این وظایف فراهم می کند.

برای اینکه طعم PySpark را بچشید، به یک مثال ساده نگاه می کنیم.

فرض کنید یک فایل CSV با مقداری داده دارید. شما می توانید این داده ها را در یک DataFrame بارگذاری کنید و عملیات اصلی را روی آن انجام دهید.

ابتدا یک جلسه Spark ایجاد کنید:

from pyspark.sql import SparkSessionspark = SparkSession.builder.appName(“example”).getOrCreate()سپس، فایل CSV خود را در یک DataFrame بارگذاری کنید:

df = spark.read.csv(“path/to/your/file.csv”, header=True, inferSchema=True)اکنون می توانید عملیات روی این DataFrame انجام دهید. به عنوان مثال، برای فیلتر کردن داده هایی که یک ستون خاص دارای مقدار مشخصی است، می توانید از موارد زیر استفاده کنید:

filtered_df = df.filter(df[“column_name”] == “value”)همچنین میتوانید دادهها را بر اساس یک ستون گروهبندی کنید و مجموعها را محاسبه کنید، مانند میانگین مقدار یک ستون دیگر:

grouped_df = df.groupBy(“column_name”).agg({“another_column”: “avg”})اینها فقط چند نمونه از کارهایی است که می توانید با PySpark انجام دهید. این کتابخانه بسیار قدرتمند است و عملکردهای زیادی را برای کمک به پردازش و تجزیه و تحلیل داده های خود ارائه می دهد.

نتیجه

در پایان، PySpark یک ابزار فوق العاده برای هر کسی است که با داده های بزرگ کار می کند. این سریع، آسان برای استفاده، مقیاس پذیر است و به خوبی با سایر ابزارهای کلان داده ادغام می شود.

با یادگیری PySpark، می توانید تمام پتانسیل Apache Spark را باز کنید و مهارت های پردازش داده خود را به سطح بالاتری ببرید.

پس ، ادامه دهید و PySpark را امتحان کنید. از اینکه چقدر می تواند انجام دهد شگفت زده خواهید شد.

امیدواریم از این مقاله لذت برده باشید. برای مقالات بیشتر هوش مصنوعی، به turingtalks.ai مراجعه کنید.

ارسال نظر