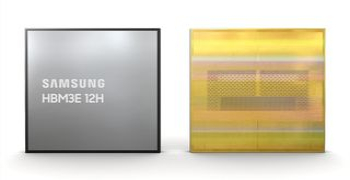

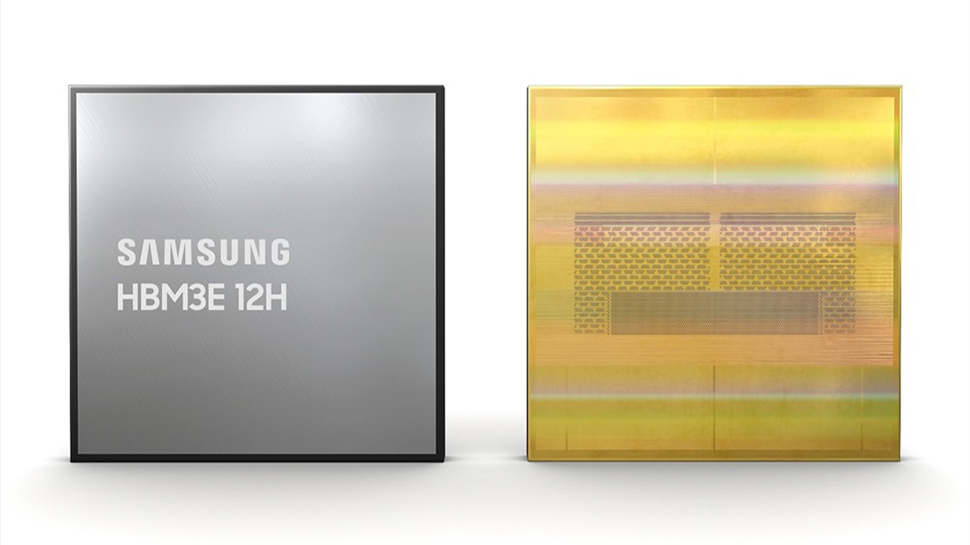

سامسونگ می گوید اولین DRAM 12 پشته ای HBM3E 12H در صنعت را توسعه داده است که از فناوری Micron پیشی گرفته و به طور بالقوه زمینه را برای نسل بعدی کارت های هوش مصنوعی انویدیا فراهم می کند.

HBM3E 12H غول فناوری کره جنوبی پهنای باند تا 1280 گیگابایت بر ثانیه و ظرفیت پیشرو در صنعت 36 گیگابایت را ارائه می دهد که نشان دهنده بهبود بیش از 50 درصدی نسبت به HBM3 8H 8 پشته ای است.

HBM3E 12H 12 پشته ای از فیلم تراکم حرارتی پیشرفته غیر رسانا (TC NCF) استفاده می کند که به محصولات 12 لایه اجازه می دهد تا شرایط فعلی بسته HBM را برآورده کنند و در عین حال مشخصات ارتفاعی مشابه با نمونه های 8 لایه را حفظ کنند. این پیشرفت ها منجر به افزایش 20 درصدی تراکم عمودی در مقایسه با محصول HBM3 8H سامسونگ شده است.

بیشتر بخوانید

Steam Deck 2 ممکن است تا سال ۲۰۲۶ وارد بازار شود، Valve آن را نمی بیند که “در چند سال آینده” عرضه شود.

نبرد داغ می شود

Yongcheol Bae، معاون اجرایی برنامه ریزی محصول حافظه در Samsung Electronics گفت: «ارائه دهندگان خدمات هوش مصنوعی صنعت به طور فزاینده ای به HBM با ظرفیت بالاتر نیاز دارند و محصول جدید HBM3E 12H ما برای پاسخگویی به این نیاز طراحی شده است. این راه حل جدید حافظه بخشی از انگیزه ما به سمت توسعه فناوری های اصلی برای HBM با پشته بالا و ارائه رهبری فناوری برای بازار HBM با ظرفیت بالا است.

در همین حال، Micron تولید انبوه 24 گیگابایت 8H HBM3E خود را آغاز کرده است که در جدیدترین پردازندههای گرافیکی H200 Tensor Core انویدیا استفاده خواهد شد. Micron ادعا می کند که HBM3E آن 30 درصد انرژی کمتری نسبت به رقبای خود مصرف می کند که آن را برای کاربردهای هوش مصنوعی مولد ایده آل می کند.

با وجود از دست دادن گرانترین کارت هوش مصنوعی انویدیا، حافظه 36 گیگابایتی HBM3E 12H سامسونگ از نظر ظرفیت و پهنای باند بهتر از Micron 24GB 8H HBM3E است. همانطور که برنامه های کاربردی هوش مصنوعی همچنان در حال رشد هستند، 12H HBM3E سامسونگ یک انتخاب واضح برای سیستم های آینده ای خواهد بود که به حافظه بیشتری نیاز دارند، مانند نیروگاه B100 Blackwell AI Nvidia که پیش بینی می شود تا پایان سال جاری وارد بازار شود.

سامسونگ در حال حاضر نمونه برداری از 36 گیگابایت HBM3E 12H خود را برای مشتریان آغاز کرده است و پیش بینی می شود تولید انبوه آن در نیمه اول سال جاری آغاز شود. Micron قرار است در سه ماهه دوم سال 2024 عرضه 24 گیگابایتی 8H HBM3E خود را آغاز کند. انتظار داریم که رقابت بین دو غول فناوری در بازار HBM تشدید شود زیرا تقاضا برای راهحلهای حافظه با ظرفیت بالا در عصر هوش مصنوعی ادامه دارد.

ارسال نظر