متا در تلاشی برای حفظ شفافیت آنلاین، پرچم گذاری تصاویر تولید شده توسط هوش مصنوعی را در فیس بوک ، اینستاگرام و Threads آغاز خواهد کرد.

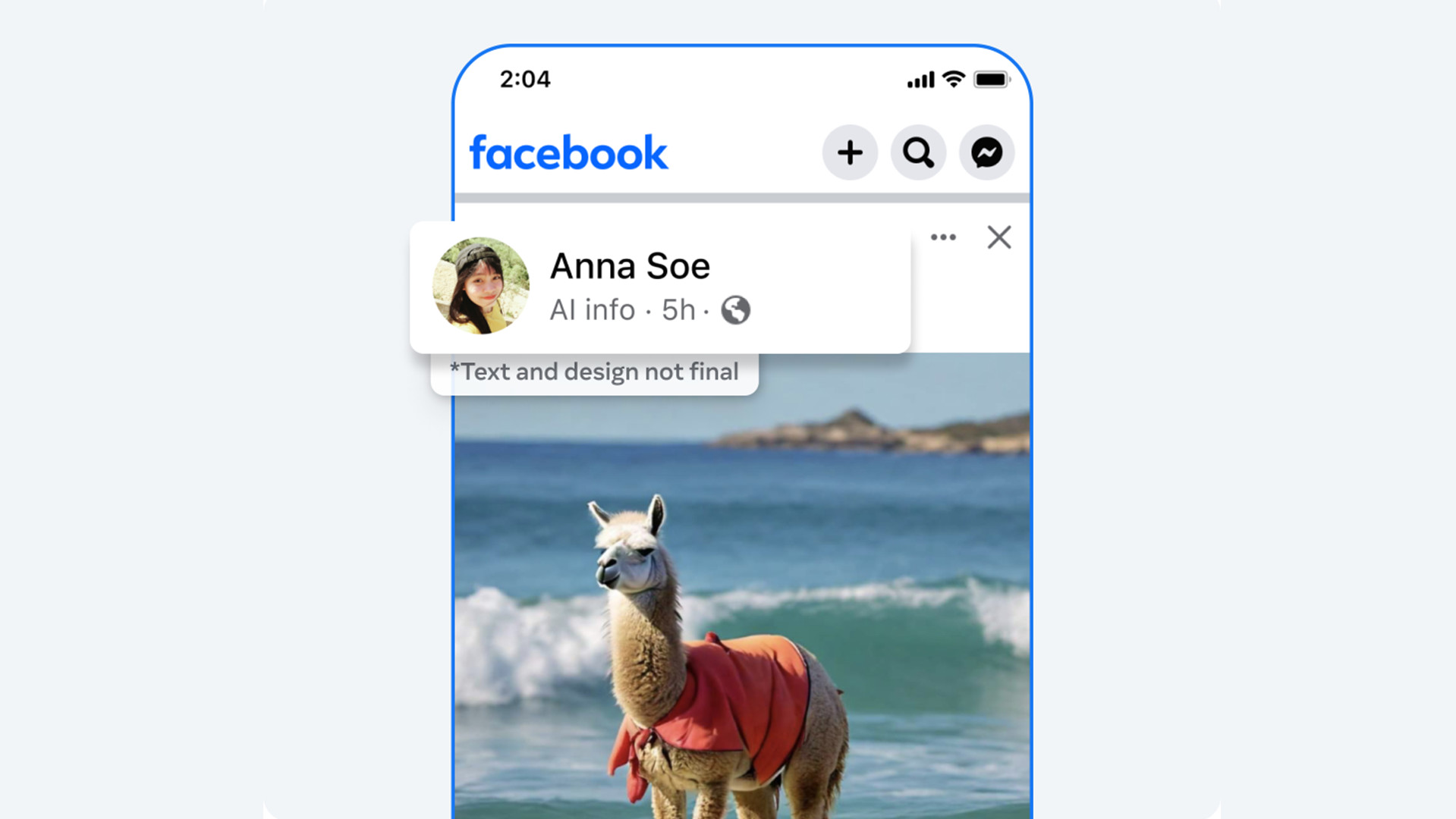

این غول فناوری محتوای تولید شده توسط موتور هوش مصنوعی Imagine خود را با یک واترمارک قابل مشاهده برچسب گذاری می کند. با حرکت رو به جلو، برای تصاویری که از منابع شخص ثالث مانند OpenAI ، Google و Midjourney میآیند، کاری مشابه انجام میدهد. دقیقاً مشخص نیست که این برچسبها چه شکلی خواهند بود، اگرچه، با نگاهی به پست اعلامیه ، ممکن است به سادگی از کلمات "AI Info" در کنار محتوای تولید شده تشکیل شده باشد. متا بیان میکند که این طراحی نهایی نیست و اشاره میکند که ممکن است پس از راهاندازی رسمی بهروزرسانی تغییر کند.

علاوه بر برچسبهای قابل مشاهده، این شرکت او میگوید که در حال کار بر روی ابزارهایی برای «شناسایی نشانگرهای نامرئی» در تصاویر تولیدکنندههای شخص ثالث است. تصور کنید هوش مصنوعی این کار را نیز با قرار دادن واترمارک در فراداده محتوای خود انجام می دهد. هدف آن گنجاندن یک برچسب منحصر به فرد است که با ابزارهای ویرایشی قابل دستکاری نیست. متا بیان میکند که پلتفرمهای دیگر نیز برنامههایی برای انجام همین کار دارند و میخواهند سیستمی برای شناسایی ابردادههای برچسبگذاری شده وجود داشته باشد.

برچسب گذاری صوتی و تصویری

تا کنون، همه چیز حول تصاویر برندسازی متمرکز بوده است، اما صدا و ویدیوی تولید شده توسط هوش مصنوعی چطور؟ Lumiere گوگل قادر به ایجاد کلیپ های فوق العاده واقع گرایانه است و OpenAI در حال کار بر روی پیاده سازی ایجاد ویدیو در ChatGPT است. آیا چیزی برای شناسایی اشکال پیچیده تری از محتوای هوش مصنوعی وجود دارد؟ خب، یه جورایی

متا اذعان دارد که در حال حاضر هیچ راهی برای تشخیص صدا و ویدیوی تولید شده توسط هوش مصنوعی در همان سطح تصاویر وجود ندارد. این فناوری هنوز وجود ندارد. با این حال، این صنعت "به سمت این قابلیت" کار می کند. تا آن زمان، این شرکت قرار است به سیستم افتخار متکی باشد. از کاربران میخواهد که فاش کنند آیا کلیپ ویدیویی یا فایل صوتی مورد نظر برای آپلود توسط هوش مصنوعی تولید یا ویرایش شده است یا خیر. عدم انجام این کار منجر به "جریمه" می شود. علاوه بر این، اگر یک قطعه رسانه آنقدر واقع بینانه باشد که خطر فریب دادن مردم را به دنبال داشته باشد، متا "برچسب برجسته تری" را که جزئیات مهمی را ارائه می دهد، به آن می چسباند.

به روز رسانی های آینده

در مورد پلتفرم های خود، متا در حال کار بر روی بهبود ابزارهای شخص اول نیز هست.

آزمایشگاه تحقیقاتی هوش مصنوعی این شرکت FAIR در حال توسعه نوع جدیدی از فناوری واترمارک به نام Stable Signature است. ظاهراً می توان نشانگرهای نامرئی را از ابرداده محتوای تولید شده توسط هوش مصنوعی حذف کرد. قرار است Sable Signature با تبدیل کردن واترمارک ها به بخشی جدایی ناپذیر از «فرایند تولید تصویر» این کار را متوقف کند. علاوه بر همه اینها، متا آموزش چندین LLM (مدل های زبان بزرگ) را بر اساس استانداردهای جامعه خود آغاز کرده است تا هوش مصنوعی بتواند تشخیص دهد که آیا محتوای خاصی این خط مشی را نقض می کند یا خیر.

پیش بینی می شود در ماه های آینده شاهد انتشار برچسب های رسانه های اجتماعی باشیم. زمان انتشار نباید تعجب آور باشد: سال 2024 یک سال انتخاباتی مهم برای بسیاری از کشورها، به ویژه ایالات متحده است. متا در تلاش است تا حد امکان از انتشار اطلاعات نادرست در پلتفرم های خود جلوگیری کند.

ما برای کسب اطلاعات بیشتر در مورد اینکه یک کاربر اگر پست خود را به اندازه کافی علامت گذاری نکند و اگر قصد دارد تصاویر را از منبع شخص ثالث با یک واترمارک قابل مشاهده علامت گذاری کند، با چه نوع جریمه هایی مواجه خواهد شد، با شرکت تماس گرفتیم. این داستان متعاقبا به روز رسانی خواهد شد.

تا آن زمان، فهرست TechRadar از بهترین تولیدکنندگان تصویر هوش مصنوعی برای سال 2024 را تحلیل کنید.

ارسال نظر