Anthropic به تازگی یک مدل جدید به نام Claude 3.7 Sonnet را منتشر کرده است، و در حالی که من همیشه به آخرین قابلیت های هوش مصنوعی علاقه مند هستم، این حالت جدید "توسعه" بود که واقعاً توجه من را به خود جلب کرد. این به من یادآوری کرد که چگونه OpenAI اولین بار مدل o1 خود را برای ChatGPT معرفی کرد. با استفاده از مدل ChatGPT 4o، راهی برای دسترسی به o1 بدون ترک پنجره ارائه می دهد. می توانید «/reason» را تایپ کنید و چت ربات هوش مصنوعی به جای آن از o1 استفاده می کند. در حال حاضر اضافی است، اگرچه هنوز روی برنامه کار می کند. صرف نظر از این، استدلال عمیقتر و ساختارمندتر که هر دو وعده داده بودند باعث شد که ببینم آنها در برابر یکدیگر چگونه عمل خواهند کرد.

حالت Extended Claude 3.7 به عنوان یک ابزار استدلال ترکیبی طراحی شده است که به کاربران این امکان را می دهد که بین پاسخ های سریع و مکالمه ای و حل عمیق و گام به گام مسئله جابجا شوند. تجزیه و تحلیل درخواست شما قبل از ارائه پاسخ زمان می برد. این آن را برای ریاضی، کدنویسی و منطق عالی می کند. شما حتی می توانید تعادل بین سرعت و عمق را به خوبی تنظیم کنید و به آن یک محدودیت زمانی بدهید تا در مورد واکنش خود فکر کند. Anthropic این را به عنوان راهی برای مفیدتر کردن هوش مصنوعی برای برنامههای کاربردی دنیای واقعی که نیاز به حل مسئله لایهای و روشمند دارند، در مقابل پاسخهای سطحی قرار میدهد.

دسترسی به Claude 3.7 نیاز به اشتراک در Claude Pro دارد، بنابراین تصمیم گرفتم از نمایش ویدیوی زیر به عنوان آزمایش خود استفاده کنم. برای به چالش کشیدن حالت تفکر گسترده، آنتروپیک از هوش مصنوعی خواست تا معمای احتمالی محبوب و قدیمی معروف به مشکل مونتی هال را تجزیه و تحلیل و توضیح دهد. این یک سوال فریبنده فریبنده است که بسیاری از افراد، حتی آنهایی که خود را در ریاضیات خوب می دانند، دچار مشکل می کند.

تنظیم ساده است: شما در یک نمایش بازی هستید و از شما خواسته می شود یکی از سه در را انتخاب کنید. پشت یکی یک ماشین است. پشت بقیه، بزها. آنتروپیک در یک هوس تصمیم گرفت به جای بز با خرچنگ ها همراه شود، اما اصل یکسان است. پس از انتخاب خود، میزبان که می داند پشت هر در چه چیزی است، یکی از دو درب باقی مانده را باز می کند تا یک بز (یا خرچنگ) را نشان دهد. حالا شما یک انتخاب دارید: به انتخاب اصلی خود بچسبید یا به آخرین در باز نشده بروید. بسیاری از مردم تصور می کنند که این مهم نیست، اما به طور غیرمستقیم، تغییر در واقع 2/3 شانس برنده شدن را به شما می دهد، در حالی که پایبندی به انتخاب اول شما را با احتمال 1/3 باقی می گذارد.

انتخاب های خرچنگ

با فعال کردن Extended Thinking، Claude 3.7 رویکردی سنجیده و تقریباً آکادمیک برای توضیح این مشکل اتخاذ کرد. به جای اینکه فقط پاسخ صحیح را بیان کند، منطق زیربنایی را در چند مرحله به دقت بیان کرد و تاکید کرد که چرا بعد از اینکه میزبان یک خرچنگ را نشان می دهد، احتمالات تغییر می کند. این فقط در اصطلاحات ریاضی خشک توضیح نمی داد. کلود سناریوهای فرضی را اجرا کرد و نشان داد که چگونه احتمالات در آزمایشهای مکرر انجام میشوند و درک اینکه چرا تغییر همیشه حرکت بهتر است، بسیار آسانتر میشود. پاسخ عجله نداشت. احساس میکردم که پروفسوری مرا به شیوهای آهسته و آگاهانه راهنمایی میکند و مطمئن میشود که من واقعاً درک کردهام که چرا شهود رایج اشتباه است.

ChatGPT o1 فقط بخش اعظمی از تفکیک را ارائه کرد و موضوع را به خوبی توضیح داد. در واقع، آن را در اشکال و سبک های متعدد توضیح داد. همراه با احتمال اولیه، از تئوری بازی، دیدگاههای روایی، تجربه روانشناختی و حتی یک فروپاشی اقتصادی نیز گذشت. اگر چیزی بود، کمی طاقت فرسا بود.

گیم پلی

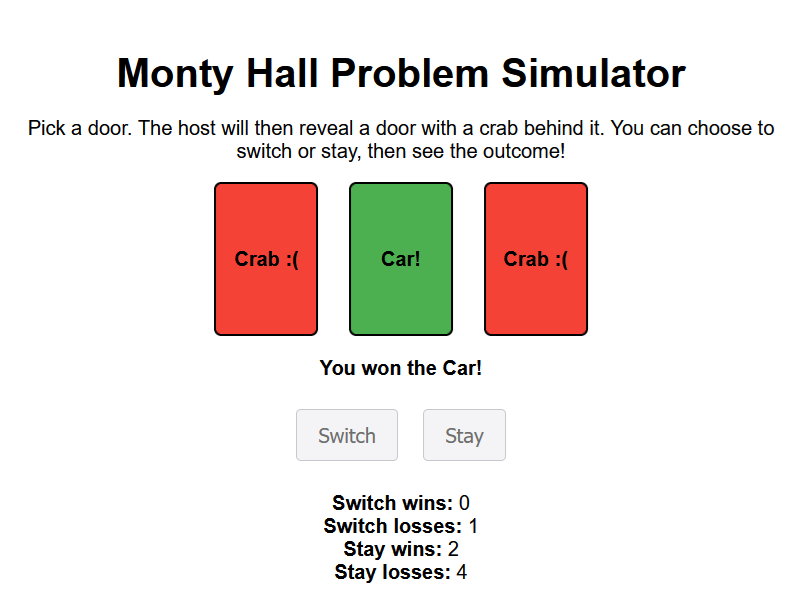

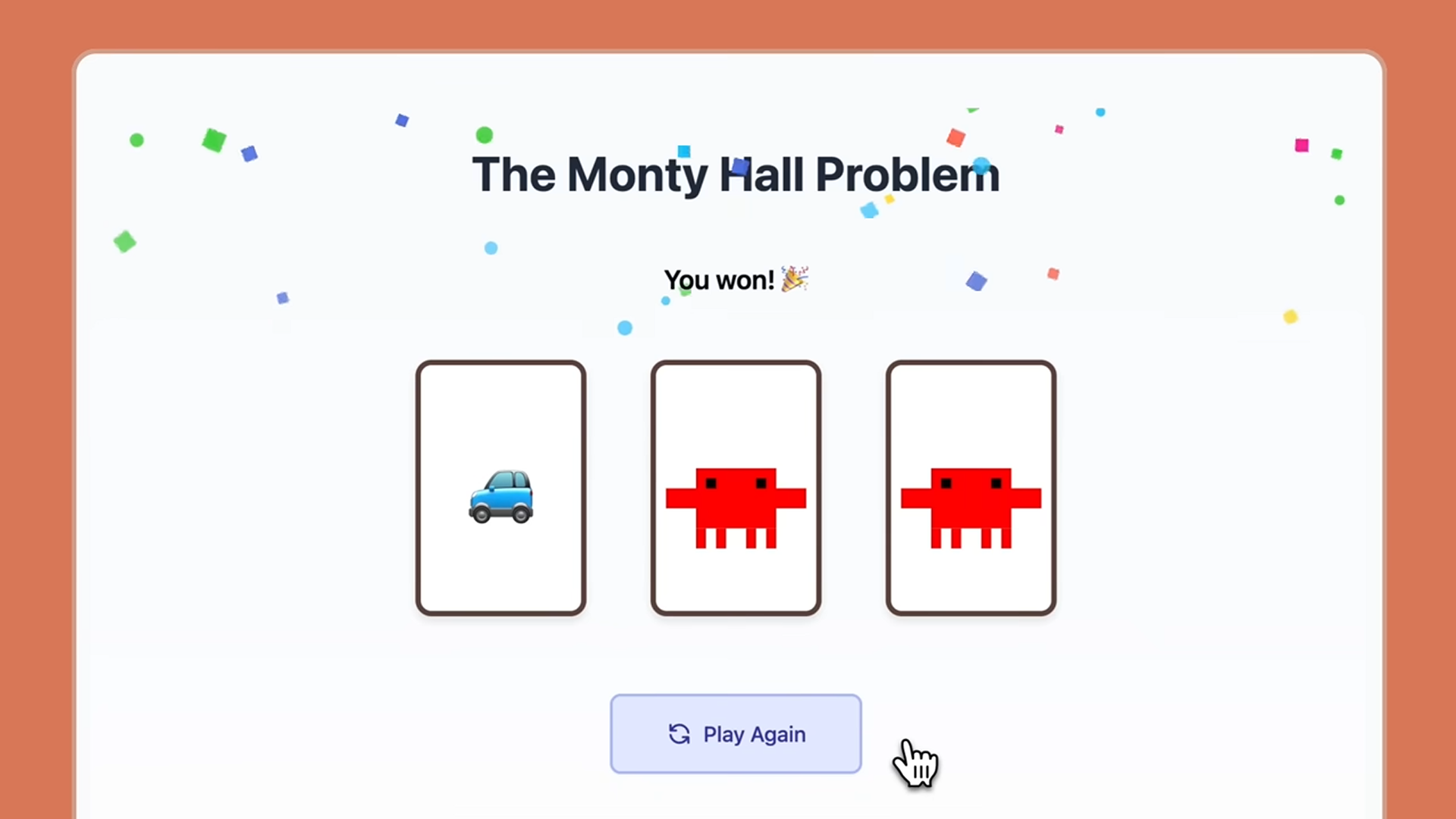

با این حال، این تمام آن چیزی نیست که تفکر گسترده کلود می تواند انجام دهد. همانطور که در ویدیو می بینید، کلود حتی توانست نسخه ای از مشکل مونتی هال را به بازی تبدیل کند که می توانید مستقیماً در پنجره بازی کنید. تلاش برای همان درخواست با ChatGPT o1 دقیقاً همین کار را انجام نداد. در عوض، ChatGPT یک اسکریپت HTML برای شبیهسازی مشکل نوشت که میتوانم آن را ذخیره و در مرورگرم باز کنم. همانطور که در زیر می بینید کار کرد، اما چند مرحله اضافی انجام داد.

در حالی که تقریباً به طور قطع بسته به نوع کد یا ریاضیی که روی آن کار می کنید، تفاوت های کوچکی در کیفیت وجود دارد، هر دو تفکر توسعه یافته کلود و مدل o1 ChatGPT رویکردهای تحلیلی و محکمی را برای مسائل منطقی ارائه می دهند. من می توانم مزیت تنظیم زمان و عمق استدلالی که کلود ارائه می دهد را ببینم. گفتنی است، مگر اینکه واقعاً عجله داشته باشید یا تجزیه و تحلیل غیرمعمول سنگینی بخواهید، ChatGPT زمان زیادی را نمی گیرد و محتوای بسیار زیادی را از تفکر خود تولید می کند.

توانایی ارائه مشکل به صورت شبیه سازی در چت بسیار قابل توجه تر است. این باعث میشود که کلود انعطافپذیرتر و قدرتمندتر شود، حتی اگر شبیهسازی واقعی احتمالاً از کد بسیار مشابه با HTML نوشته شده توسط ChatGPT استفاده کند.

ارسال نظر