سربراس جدیدترین تراشه استنتاج هوش مصنوعی خود را که به عنوان رقیب سرسخت DGX100 انویدیا معرفی می شود، رونمایی کرد.

این تراشه دارای 44 گیگابایت حافظه پرسرعت است که به آن امکان می دهد مدل های هوش مصنوعی با میلیاردها تا تریلیون ها پارامتر را مدیریت کند.

برای مدلهایی که از ظرفیت حافظه یک ویفر فراتر میروند، Cerebras میتواند آنها را در مرزهای لایه تقسیم کند و آنها را در چندین سیستم CS-3 توزیع کند. یک سیستم CS-3 منفرد میتواند 20 میلیارد مدل پارامتر را در خود جای دهد، در حالی که 70 میلیارد مدل پارامتری را میتوان تنها با چهار سیستم مدیریت کرد.

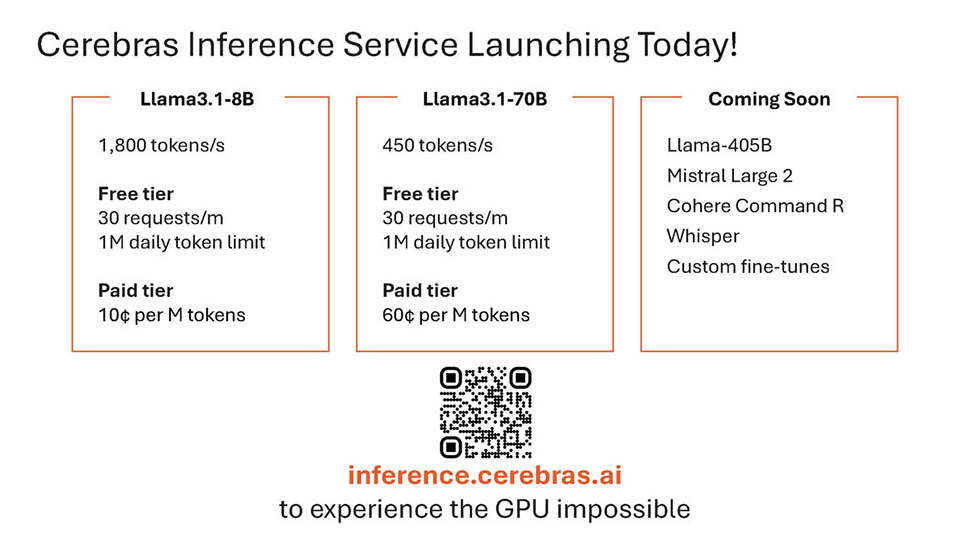

پشتیبانی مدل اضافی به زودی

Cerebras بر استفاده از وزنههای مدل 16 بیتی برای حفظ دقت تأکید میکند، برخلاف برخی از رقبا که دقت وزن را به 8 بیت کاهش میدهند که میتواند عملکرد را کاهش دهد. به گفته سربراس، مدلهای 16 بیتی آن تا 5 درصد در مکالمات چند نوبتی، ریاضی و کارهای استدلالی در مقایسه با مدلهای 8 بیتی بهتر عمل میکنند و از خروجیهای دقیقتر و مطمئنتر اطمینان میدهند.

پلتفرم استنتاج Cerebras از طریق چت و دسترسی API در دسترس است و به گونه ای طراحی شده است که به راحتی توسط توسعه دهندگان آشنا با فرمت Chat Completions OpenAI ادغام شود. این پلتفرم دارای توانایی اجرای مدل های Llama3.1 70B با سرعت 450 توکن در ثانیه است که تنها راه حل برای دستیابی به سرعت آنی برای چنین مدل های بزرگی است. برای توسعه دهندگان، Cerebras روزانه 1 میلیون توکن رایگان در هنگام راه اندازی ارائه می دهد، که گفته می شود قیمت برای استقرار در مقیاس بزرگ به طور قابل توجهی کمتر از ابرهای GPU محبوب است.

سربراس در ابتدا با مدلهای Llama3.1 8B و 70B عرضه میشود و قصد دارد در آینده نزدیک از مدلهای بزرگتری مانند Llama3 405B و Mistral Large 2 پشتیبانی کند. این شرکت تاکید میکند که قابلیتهای استنتاج سریع برای فعال کردن گردشهای کاری پیچیدهتر هوش مصنوعی و افزایش هوش LLM در زمان واقعی، به ویژه در تکنیکهایی مانند داربست، که به استفاده قابل توجهی از توکن نیاز دارد، بسیار مهم است.

پاتریک کندی از ServeTheHome این محصول را در سمپوزیوم اخیر Hot Chips 2024 دیدم و بيان کرد : «من این فرصت را داشتم که قبل از صحبت با اندرو فلدمن (مدیر عامل Cerebras) بنشینم و او دموها را به صورت زنده به من نشان داد. به طرز فحشی سریع است. دلیل اهمیت این موضوع فقط این نیست که انسان تعامل سریعی داشته باشد. در عوض، در دنیایی از عوامل که در آن عوامل هوش مصنوعی کامپیوتر با چندین عامل دیگر هوش مصنوعی صحبت می کنند. تصور کنید که چند ثانیه طول می کشد تا هر عامل با خروجی بیرون بیاید، و چندین مرحله در آن خط لوله وجود دارد. اگر به خطوط لوله خودکار عامل هوش مصنوعی فکر می کنید، به استنباط سریع برای کاهش زمان برای کل زنجیره نیاز دارید.

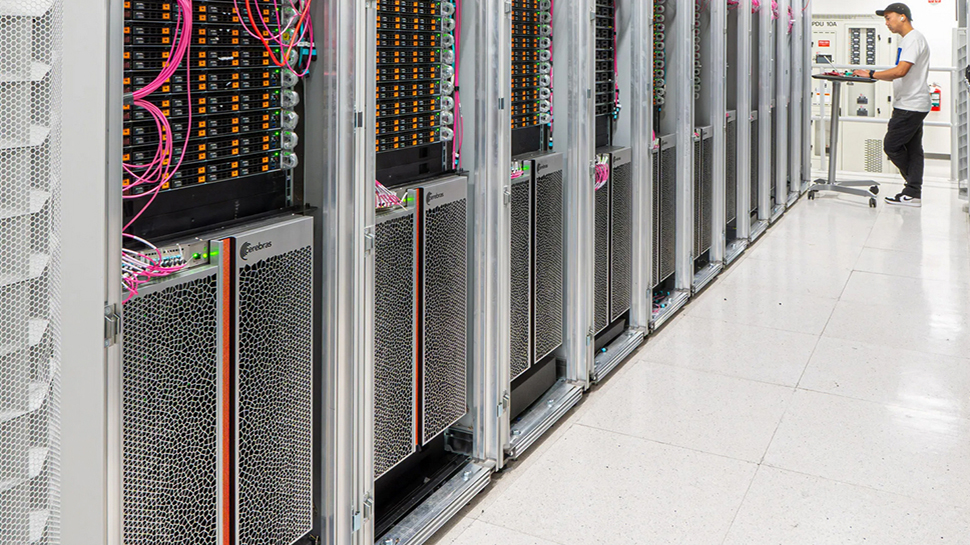

Cerebras پلت فرم خود را به عنوان یک استاندارد جدید در توسعه و استقرار LLM باز، ارائه عملکرد رکوردشکنی، قیمت رقابتی و دسترسی گسترده API قرار می دهد. می توانید با رفتن به inference.cerebras.ai یا با اسکن کد QR در اسلاید زیر آن را امتحان کنید.

ارسال نظر