این هفته در هوش مصنوعی: وقتی «متن باز» چندان باز نیست

همگام شدن با صنعتی که به سرعت هوش مصنوعی در حال حرکت است، امری دشوار است. پس تا زمانی که یک هوش مصنوعی بتواند این کار را برای شما انجام دهد، در اینجا خلاصهای مفید از داستانهای اخیر در دنیای یادگیری ماشین، همراه با تحقیقات و آزمایشهای قابلتوجهی است که به تنهایی پوشش ندادهایم.

این هفته، متا جدیدترین مدلهای AI از سری Llama خود را منتشر کرد: Llama 3 8B و Llama 3 70B. متا بيان کرد که این مدلها که قادر به تجزیه و تحلیل و نوشتن متن هستند، "متن باز" هستند - در نظر گرفته شده تا "قطعه ای اساسی" از سیستم هایی باشند که توسعه دهندگان با اهداف منحصر به فرد خود طراحی می کنند.

متا در یک پست وبلاگ نوشت: "ما معتقدیم که اینها بهترین مدل های منبع باز در کلاس خود هستند." "ما در حال پذیرفتن اخلاق منبع باز انتشار زودهنگام و اغلب هستیم."

تنها یک مشکل وجود دارد: مدلهای Llama 3 واقعاً «متنباز» نیستند، حداقل در دقیقترین تعریف.

منبع باز به این معنی است که توسعه دهندگان می توانند بدون محدودیت از مدل ها استفاده کنند. اما در مورد Llama 3 - مانند Llama 2 - Meta محدودیتهای صدور مجوز خاصی را اعمال کرده است. به عنوان مثال، مدل های Llama را نمی توان برای آموزش مدل های دیگر استفاده کرد. و توسعه دهندگان برنامه با بیش از 700 میلیون کاربر ماهانه باید مجوز خاصی را از متا درخواست کنند.

بحث در مورد تعریف منبع باز جدید نیست. اما از آنجایی که شرکتهای موجود در فضای هوش مصنوعی با این اصطلاح سریع و بیپرده بازی میکنند، این اصطلاح به بحثهای فلسفی طولانیمدت سوخت تزریق میکند.

آگوست گذشته، مطالعهای که توسط محققان کارنگی ملون، مؤسسه AI Now و بنیاد سیگنال انجام شد، نشان داد که بسیاری از مدلهای هوش مصنوعی که بهعنوان «منبع باز» نامگذاری شدهاند، دارای جذابیتهای بزرگ هستند - نه فقط لاما. داده های مورد نیاز برای آموزش مدل ها مخفی نگه داشته می شود. قدرت محاسباتی مورد نیاز برای اجرای آنها خارج از دسترس بسیاری از توسعه دهندگان است. و نیروی کار برای تنظیم دقیق آنها بسیار گران است.

پس اگر این مدلها واقعاً منبع باز نیستند، دقیقاً چه هستند؟ این سوال خوبی است. تعریف منبع باز با توجه به هوش مصنوعی کار آسانی نیست.

یک سوال حل نشده مرتبط این است که آیا کپی رایت، مکانیزم اساسی IP مبتنی بر مجوز منبع باز، می تواند برای اجزا و قطعات مختلف یک پروژه هوش مصنوعی، به ویژه داربست داخلی یک مدل (مثلاً جاسازی ها) اعمال شود. سپس، عدم تطابق بین درک منبع باز و نحوه عملکرد هوش مصنوعی برای غلبه بر وجود دارد: منبع باز تا حدودی برای اطمینان از اینکه توسعه دهندگان می توانند کد را بدون محدودیت مطالعه و اصلاح کنند، ابداع شد. با این حال، با هوش مصنوعی، این که کدام مواد برای مطالعه و اصلاح نیاز دارید، قابل تفسیر است.

مطالعه Carnegie Mellon با تمام ابهامات، آسیب ذاتی غولهای فناوری مانند Meta را روشن میکند که عبارت «منبع باز» را انتخاب میکنند.

اغلب، پروژههای «متن باز» هوش مصنوعی مانند Llama در نهایت چرخههای خبری – بازاریابی رایگان – را آغاز میکنند و مزایای فنی و استراتژیک را برای نگهبانان پروژهها فراهم میکنند. جامعه منبع باز به ندرت این مزایای مشابه را می بیند، و زمانی که می بینند، در مقایسه با نگهدارنده ها حاشیه ای هستند.

به گفته نویسندگان همکار این مطالعه، به جای دموکراتیک کردن هوش مصنوعی، پروژههای هوش مصنوعی «منبع باز» - به ویژه پروژههای شرکتهای بزرگ فناوری - تمایل به تقویت و گسترش قدرت متمرکز دارند. این خوب است که دفعه بعد که نسخه اصلی مدل "متن باز" منتشر شد، به خاطر داشته باشید.

در اینجا برخی دیگر از داستان های هوش مصنوعی قابل توجه در چند روز گذشته آورده شده است:

متا چت بات خود را به روز می کند: همزمان با اولین نمایش Llama 3، متا چت ربات هوش مصنوعی خود را در فیس بوک، مسنجر، اینستاگرام و واتس اپ - Meta AI - با یک باطن مجهز به Llama 3 ارتقا داد. همچنین ویژگی های جدیدی از جمله تولید سریعتر تصویر و دسترسی به نتایج جستجوی وب را راه اندازی کرد.

پورن تولید شده توسط هوش مصنوعی: ایوان در مورد اینکه چگونه هیئت نظارت، شورای سیاست گذاری نیمه مستقل متا، توجه خود را به نحوه برخورد پلتفرم های اجتماعی این شرکت با تصاویر واضح و تولید شده توسط هوش مصنوعی معطوف می کند، می نویسد.

اسنپ واترمارک: سرویس رسانه های اجتماعی اسنپ قصد دارد به تصاویر تولید شده توسط هوش مصنوعی در پلتفرم خود واترمارک اضافه کند. یک نسخه شفاف از لوگوی اسنپ با یک ایموجی درخشان، واترمارک جدید به هر تصویر تولید شده توسط هوش مصنوعی که از برنامه صادر می شود یا در رول دوربین ذخیره می شود، اضافه می شود.

اطلس جدید: شرکت رباتیک متعلق به هیوندای بوستون داینامیکس از نسل بعدی ربات انسان نما اطلس خود رونمایی کرده است که بر خلاف نسل قبلی خود که با موتور هیدرولیک کار می کند، تمام الکتریکی است - و از نظر ظاهری بسیار دوستانه تر است.

Humanoids on Humanoids: Boston Dynamics، بنیانگذار Mobileye، Amnon Shashua، استارت آپ جدیدی به نام Menteebot راه اندازی کرده است که بر ساخت سیستم های رباتیک بیادال تمرکز دارد. یک ویدئوی نمایشی، نمونه اولیه Menteebot را نشان میدهد که به سمت یک میز میرود و میوه میگیرد.

Reddit، ترجمه: در مصاحبه ای با آماندا، پالی بات، مدیر ارشد اجرایی Reddit فاش کرد که یک ویژگی ترجمه زبان مبتنی بر هوش مصنوعی برای رساندن شبکه اجتماعی به مخاطبان جهانی تر، همراه با یک ابزار تعدیل کمکی که در مورد گذشته مدیران Reddit آموزش دیده است، در دست ساخت است. تصمیمات و اقدامات

محتوای لینکدین تولید شده توسط هوش مصنوعی: لینکدین بی سر و صدا شروع به آزمایش روش جدیدی برای افزایش درآمد خود کرده است: اشتراک صفحه شرکت پریمیوم لینکدین، که - برای هزینه هایی که به نظر می رسد به اندازه 99 دلار در ماه باشد - شامل هوش مصنوعی برای نوشتن محتوا و مجموعه ای از ابزاری برای افزایش تعداد فالوورها

A Bellwether: کارخانه مادر الفبای گوگل، X، این هفته از پروژه Bellwether، آخرین پیشنهاد خود برای به کارگیری فناوری برای برخی از بزرگترین مشکلات جهان، رونمایی کرد. در اینجا، این به معنای استفاده از ابزارهای هوش مصنوعی برای شناسایی بلایای طبیعی مانند آتش سوزی و سیل در سریع ترین زمان ممکن است.

محافظت از کودکان با هوش مصنوعی: آفکام، رگولاتوری که مسئول اجرای قانون ایمنی آنلاین بریتانیا است، قصد دارد کاوشی در مورد چگونگی استفاده از هوش مصنوعی و سایر ابزارهای خودکار برای شناسایی فعال و حذف محتوای غیرقانونی آنلاین، به ویژه برای محافظت از کودکان در برابر محتوای مضر، آغاز کند.

OpenAI در ژاپن فرود آمد: OpenAI با افتتاح دفتر جدید توکیو و برنامه ریزی برای مدل GPT-4 که به طور خاص برای زبان ژاپنی بهینه شده است، در حال گسترش به ژاپن است.

یادگیری ماشینی بیشتر

اعتبار تصویر: DrAfter123 / Getty Images

آیا یک چت بات می تواند نظر شما را تغییر دهد؟ محققان سوئیسی دریافتند که نه تنها می توانند، بلکه اگر از قبل به برخی اطلاعات شخصی در مورد شما مجهز شده باشند، در واقع می توانند در یک بحث متقاعد کننده تر از انسانی با همان اطلاعات باشند.

رابرت وست، سرپرست پروژه از EPFL گفت: "این کمبریج آنالیتیکا روی استروئیدها است. " محققان بر این باورند که مدل - GPT-4 در این مورد - از فروشگاههای وسیع استدلالها و حقایق آنلاین برای ارائه یک مورد قانعکنندهتر و مطمئنتر استخراج شده است. اما نتیجه به نوعی خود صحبت می کند. وست هشدار داد که قدرت LLM ها را در مسائل متقاعدسازی دست کم نگیرید: «در زمینه انتخابات آتی ایالات متحده، مردم نگران هستند زیرا این نوع فناوری همیشه برای اولین بار در نبرد مورد آزمایش قرار می گیرد. چیزی که ما به طور قطع می دانیم این است که مردم از قدرت مدل های زبانی بزرگ برای تغییر در انتخابات استفاده خواهند کرد. "

به هر حال چرا این مدل ها در زبان اینقدر خوب هستند؟ این یکی از حوزههایی است که سابقه طولانی تحقیق در مورد آن وجود دارد، به ELIZA. اگر در مورد یکی از افرادی که برای بسیاری از آن حضور داشته اند (و خودش هم آن را اجرا کرده است) کنجکاو هستید، این نمایه را در کریستوفر منینگ از استانفورد تحلیل کنید. او به تازگی مدال جان فون نیومن را دریافت کرد. تبریک

در مصاحبهای با عنوان تحریکآمیز، یکی دیگر از محققین بلندمدت هوش مصنوعی (که مرحله TechCrunch را نیز زیبا کرده است)، استوارت راسل، و مایکل کوهن، فوق دکترا، در مورد «چگونه هوش مصنوعی را از کشتن همه ما جلوگیری کنیم» حدس و گمان میزنند. احتمالاً چیز خوبی است که زودتر بفهمیم! با این حال، این یک بحث سطحی نیست - این افراد باهوشی هستند که در مورد اینکه چگونه میتوانیم واقعاً انگیزههای مدلهای هوش مصنوعی را درک کنیم (اگر این کلمه درست باشد) و اینکه چگونه مقررات باید حول آنها ایجاد شود، صحبت میکنند.

این مصاحبه در واقع مربوط به مقالهای است که در اوایل این ماه در Science منتشر شد، که در آن آنها پیشنهاد میکنند که آزمایش هوش مصنوعی پیشرفته که قادر به عمل استراتژیک برای دستیابی به اهداف خود هستند، که آنها را «عاملهای برنامهریزی بلندمدت» مینامند، ممکن است غیرممکن باشد. اساساً، اگر مدلی یاد بگیرد که آزمایشی را که باید برای موفقیت پشت سر بگذارد، "درک" کند، ممکن است به خوبی روش هایی را بیاموزد که خلاقانه آن آزمایش را نفی یا دور بزند. ما آن را در مقیاس کوچک دیدهایم، چرا در مقیاس بزرگ نه؟

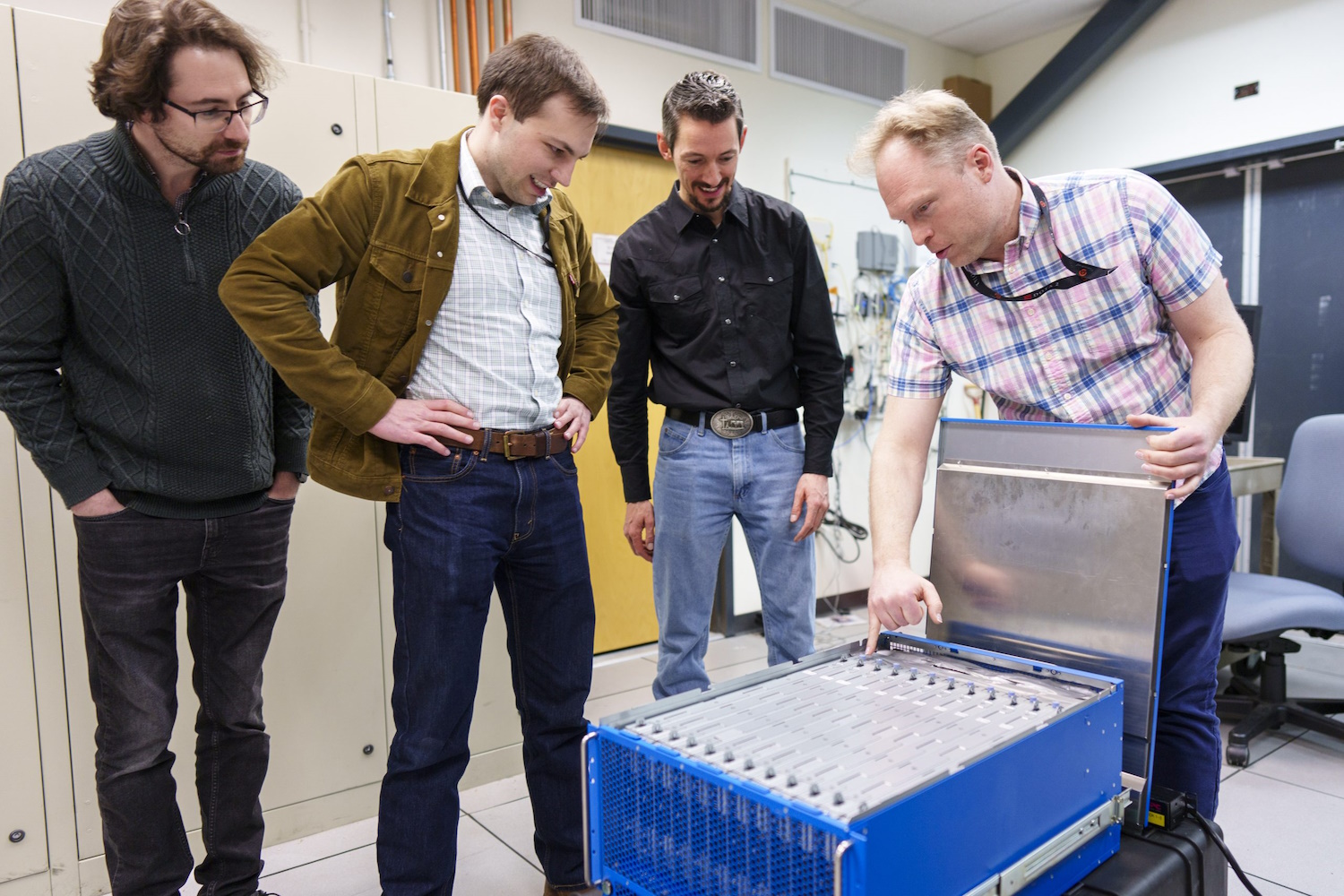

راسل پیشنهاد میکند سختافزار مورد نیاز برای ساخت چنین عواملی را محدود کند... اما البته، آزمایشگاههای ملی لوس آلاموس و ساندیا به تازگی محصولات خود را دریافت کردهاند. LANL به تازگی مراسم برش روبان را برای Venado، ابررایانه جدیدی که برای تحقیقات هوش مصنوعی در نظر گرفته شده، متشکل از 2560 تراشه Grace Hopper Nvidia برگزار کرده است.

و ساندیا به تازگی «یک سیستم محاسباتی خارقالعاده مبتنی بر مغز به نام Hala Point» با 1.15 میلیارد نورون مصنوعی را دریافت کرده است که توسط اینتل ساخته شده و گمان میرود بزرگترین چنین سیستمی در جهان باشد. محاسبات نورومورفیک، همانطور که از آن نام برده میشود، برای جایگزینی سیستمهایی مانند Venado نیست، بلکه برای دنبال کردن روشهای محاسباتی جدید است که بیشتر شبیه به روشهای مبتنی بر آمار است که در مدلهای مدرن میبینیم.

با این سیستم میلیارد نورونی، ما فرصتی برای نوآوری در مقیاس الگوریتمهای جدید هوش مصنوعی خواهیم داشت که ممکن است کارآمدتر و هوشمندتر از الگوریتمهای موجود باشند و رویکردهای مغز مانند جدید برای الگوریتمهای رایانهای موجود مانند بهینهسازی و مدلسازی. براد ایمون محقق ساندیا. شیک به نظر می رسد ... فقط شیک!

ارسال نظر